Agora a integração com o Chat GPT está nativo no Wide Chat, trazendo alguns parâmetros de configuração dentro da tela do Administrador e na tela de atendimento do agente.

Observação: Necessário criar conta no Open AI e criar o APIKEY de consulta. Segue link para obter chave para integração. Caso tenha dúvidas de como realizar a criação do API KEY, temos uma documentação de apoio neste link.

1. Usando Dentro do Fluxo de Atendimento

Contextos

É onde é definido como o sistema deve se comportar para responder as perguntas feitas no bot. Isso é uma melhoria considerável no uso da NLP, não sendo necessário criar as formas que o cliente vai perguntar, somente a diretriz de como o CHAT GPT deve responder.

Observação: Sempre limitar o contexto, pois o Chat GPT é uma ferramenta que sempre dará uma resposta. Para garantir que não responda algo desejado, usamos a função do contexto para isso, como o exemplo abaixo, usado para perguntas e respostas sobre a empresa/produto:

Observe que foi usada a expressão: “Encontrar melhor assunto entre os itens a seguir e imprimi-lo literalmente:”. E então foram listadas todas as opções que o bot deve avaliar, e caso encontre um assunto relacionado à pergunta, retorna o conteúdo do item

Abaixo texto usado dentro da FAQ Wide Chat:

Encontrar melhor assunto entre os itens a seguir e imprimi-lo literalmente: 1. Vídeo informativo sobre as 10 principais funcionalidades do Wide Chat: capacidade de unificar canais; fluxo de atendimento; webchat ativo; monitoramento em tempo real; geração de relatórios; integrações; criação de scripts; análise de sentimentos; transcrição de áudio (STT); tradução automática bilateral. Link: https://basedeconhecimento.intelbras.com.br/support/solutions/articles/151000087117 2. Tutorial de como alterar a senha de usuário na plataforma Wide Chat. Link: https://basedeconhecimento.intelbras.com.br/support/solutions/articles/151000038122 3. Tutorial de apoio para ensinar a criar a credencial de acesso dentro da RD Station, para que possa ser consumido as API´s do produto através do Wide Chat. Link: https://basedeconhecimento.intelbras.com.br/support/solutions/articles/151000087544 Senão imprimir: Este assunto não é válido! |

Observação: Sempre limitar o contexto, pois o Chat GPT é uma ferramenta que sempre dará uma resposta. Para garantir que não responda algo indesejado, usamos sempre dentro do contexto, a seguinte informação: “Senão imprimir: Este assunto não é válido!”.

Criar API REST - Uso Fluxo de Atendimento

Acessar a parte de Integrações - Rest - Aplicativos e incluir um novo modelo:

Abaixo um exemplo do modelo:

Cabeçalho:

{

"Content-Type": "application/json",

"Authorization": "Bearer {{TOKEN}}"

}Body:

{

"model": "gpt-3.5-turbo-16k",

"messages": [

{

"role": "system",

"content": "{{CONTEXT_ASSISTANT}}"

},

{

"role": "user",

"content": "{{PROMPT}}"

}

],

"temperature": 1,

"max_tokens": 256,

"top_p": 1,

"frequency_penalty": 0,

"presence_penalty": 0

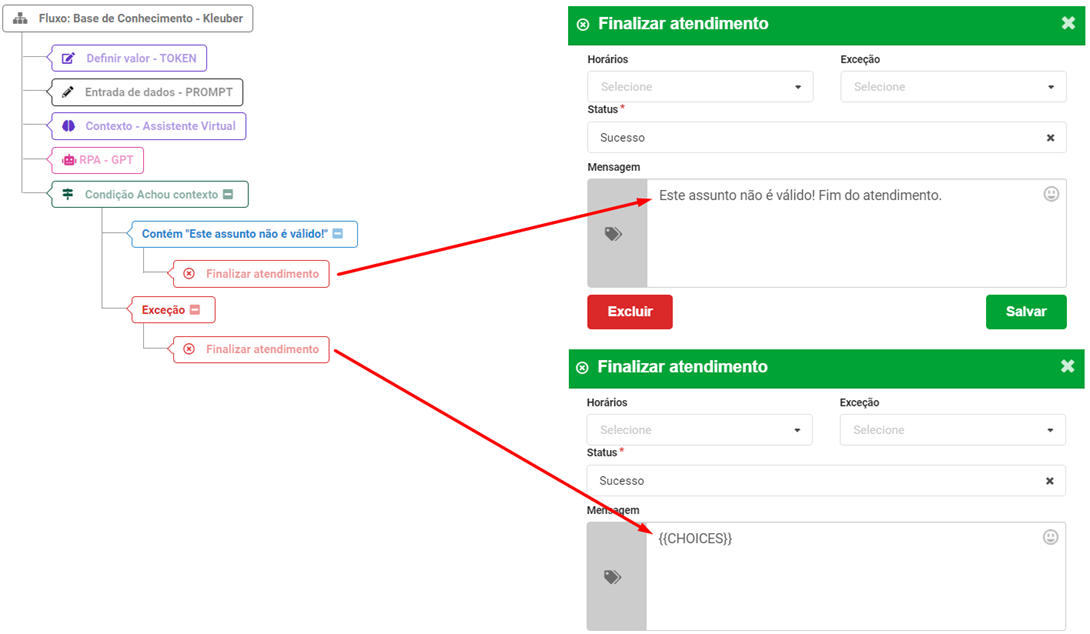

}Exemplo da montagem do fluxo:

Definir TOKEN

Definir entrada de dados

Definir contexto

Definir RPA

{

"choices": [

{

"message": {

"content": "{{CHOICES}}"

}

}

]

}Importante criar a variável {{CHOICES}} no sistema para armazenar os dados da consulta.

Definir condição

Exemplo tratamento Sucesso e Falha

Importante: O modelo "gpt-3.5-turbo-16k" permite somente 16000 tokens de texto. Lembrar sempre verificar via este link https://platform.openai.com/tokenizer a quantidade de tokens do texto utilizado, pois caso contrário o ChatGPT dará erro na consulta:

2. Copilot

Essa função serve para habilitar na tela do agente para tudo que o cliente encaminhar de mensagens, usar o ChatGPT para sugerir uma modelo resposta a pergunta feita:

Para seu funcionamento, basta criar em Integrações - Rest, o aplicativo Copilot, como abaixo:

Cabeçalho:

{

"Content-Type": "application/json",

"Authorization": "Bearer {{TOKEN}}"

}Body:

{

"model": "gpt-4-1106-preview",

"messages": [

{

"role": "user",

"content": "{{PROMPT}}"

}

]

}Na parte do Copilot (ainda na configuração da Integração - Rest - Aplicativos), é possível setar o contexto fechado de pesquisa de respostas desejados para utilização:

E dentro da configuração da equipe, é habilitado ou não a utilização da função, escolhendo qual o aplicativo vai usar:

Pós atendimento

Dentro desta opção, possui dois tipos de resumos apresentado na tela de relatório de atendimento:

Resumo de Atendimento: Função que o ChatGPT é usado para fazer um resumo da conversa, disponível no relatório da conversa.

Análise de Sentimento: Função que o ChatGPT é usado para realizar como foi o sentimento do atendimento, ao final do atendimento, disponível no relatório da conversa.

Abaixo o modelo da API Rest para resumo do atendimento:

Cabeçalho:

{

"Content-Type": "application/json",

"Authorization": "Bearer {{TOKEN}}"

}Body:

{

"model": "gpt-3.5-turbo",

"messages": [

{

"role": "user",

"content": "{{PROMPT}}"

}

]

}Este artigo foi útil?

Que bom!

Obrigado pelo seu feedback

Desculpe! Não conseguimos ajudar você

Obrigado pelo seu feedback

Feedback enviado

Agradecemos seu esforço e tentaremos corrigir o artigo